发布会上,苹果将Siri宣传为“谦逊的私人助理,只需提出要求即可帮助你完成工作”,而众多媒体也不吝赞美之词。

The Verge提到:“Siri的疯狂之处在于,它的工作效果——至少在大多数时候——比你想象的要好。”

“Siri可以节省时间、减少摸索和分散注意力,并深刻改变‘手机’的定义。” 《纽约时报》称。

当时人们的眼中,Siri无疑是具备一定革命性的,尽管它还不是那么完美,会犯一些机器都会犯的错,但却有了人工智能的雏形,尽管苹果没有用“人工智能(Artificial Intelligence)”来形容它,但苹果高管Phil Schiller在发布Siri的时候,心里大概还是会闪过1999年《机器管家》电影里的某个片段。

但是苹果却在这之后和AI分道扬镳,渐行渐远。在今年6月的WWDC上,苹果只字未提AI,只是用了机器学习来指代这两个字母,而曾经苹果引以为傲的Siri,却被一笔带过,只是把语音唤醒词简化成“Siri”,并加入了连续回应功能,相较于其他互联网公司在语音助手上的大刀阔斧式的更新,Siri更像是小心翼翼地挤出了一点牙膏,颇有些敷衍了事的感觉。

瑞士信贷(Credit Suisse)的资深分析师香农-克罗斯(Shannon Cross)在5月的苹果财报会议上,直截了当地询问CEO库克,问他对人工智能是否有话要说。

库克依旧是那个四平八稳的回答风格:“苹果在整合生态系统中的人工智能和机器学习方面取得了巨大进步,多年来我们一直将其融入到产品和功能中,你可以在跌倒检测、碰撞检测和心电图等方面看到这一点。因此,我们认为人工智能是一项巨大的技术,苹果将继续深思熟虑地将其应用到产品中。”

但苹果确实拿不出更多关于AI方面的成果,在元宇宙的热潮逐渐褪去的今年,苹果却发布了头显Vision Pro,售价3万多的它,显然不如Chat-GPT那样接地气,也让更多人心生怀疑,他们心中都有同一个问题:

你可能以为苹果对AI不怎么感冒,但它却是最早把AI放到宣传里的公司之一。

乔布斯离开苹果之后,CEO约翰·斯卡利(John Sculley)接过了整个公司的重担,1987年,他出版了自己的著作《奥德赛:从百事可乐到苹果》,书中的最后一章,斯卡利与艾伦·凯(Alan Kay,当时的苹果研究员)在多次讨论后提出了一个设想,即所谓的知识导航仪(Knowledge Navigator),甚至还为它画了一个粗略的草图,屏幕上有两个操纵杆,人们可以握住操纵杆在知识的海洋中徜徉。

同年10月,学术计算机领域的主要高等教育会议Educom正式召开,斯卡利受邀做了主题演讲,《奥德赛》中的知识导航仪从铅字变成了一段生动的视频,在假想的2007年,一位伯克利大学教授准备讲座、查看电子邮件、在网上做研究、与巴西的同事视频通话、为父亲购买生日蛋糕……

这一切不是通过键鼠,而是依靠屏幕里一位打着领结的数字私人管家,伴随着乔治·安东·本达(Georg Anton Benda)的C大调羽管键琴协奏曲,在连续而又自然的一段段对话当中,完成了工作和生活中的琐碎事情。

知识导航仪在当时引起不小的轰动,既有为苹果未来愿景发出叹服的声音,也有着指责苹果不切实际的声音,1987年,个人电脑方兴未艾美国区苹果id分享2022,图形化操作系统还没普及,就想着虚拟助理了,未免有些太超前了。

事实证明,有些超前的想法并非妄想,Siri、Cortana、Alexa、Bixby 和 Google Assistant在2011年之后先后涌现,二十多年前的知识导航仪,成为了这些语音助手的曾曾曾祖父。

随着斯卡利辞任CEO,乔布斯回归苹果,知识导航仪的概念被束之高阁,但苹果并没有彻底放弃对AI的追逐,但无奈于设备性能的羸弱,没办法实现设想里的种种功能。

不过,当时对于语音助手的探索其实已经卓有成效,90年代作为处理器迭代最快的时期,得以让软件公司能够开发全面的语音识别系统,如Dragon在1997 年发布的Dragon NaturallySpeaking,这是世界上第一个每分钟理解100个单词的连续语音识别系统,用户不用在两个单词之间刻意停顿,实现了流畅的整句识别。

到了2001年时,先进的语音识别软件已经可以做到80%的识别准确率,谷歌甚至开始将这部分技术带到了实际应用中,谷歌语音搜索收集了大约2300亿个用户搜索的单词,最终将它们用于预测搜索内容,并推进了语音处理技术后续的发展。

2003年,美国国防部高级研究计划局DARPA开始对人工智能进行研究,他们希望有一个数字助手来处理每天收到的大量数据,他们与有技术积累的SRI International合作,开展了迄今最大的人工智能项目之一CALO,其意为“士兵的仆人”。

而这个项目的最大意义不在于它提供了多么尖端的武器,而是在五年的研究后,SRI International分拆出的一家名为Siri的初创公司,没错,这就是苹果Siri语音助手最初的起点。

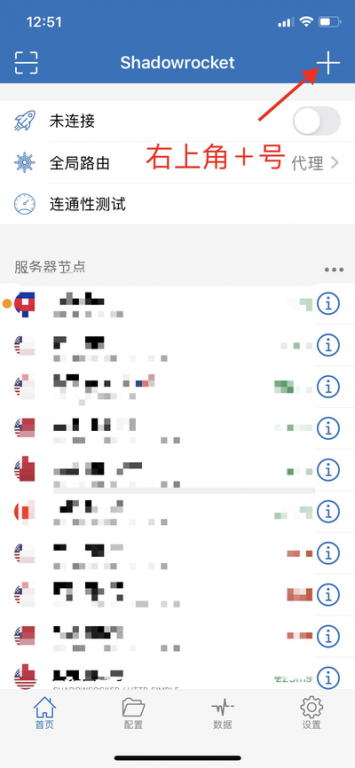

Siri在2010年初在App Store免费推出同名应用,虽然没有达到知识导航仪的水平,但它功能可以用丰富来形容,通过连接到互联网,Siri不仅可以通过 TaxiMagic 预订出租车,从StubHub了解音乐会时间,也能通过烂番茄查看电影评论,从Yelp获取餐厅评分等等,不少人觉得Siri已经接近千禧年时电影中的人工智能原型了。

原本Siri还计划在安卓和黑莓平台上推出对应的语音助手,不过刚推出没多久,苹果CEO乔布斯大手一挥,这么好的应用,就永远留在iOS系统里,在当年4月就宣布了对Siri的收购,次年10月,苹果正式推出了内置Siri测试版的iPhone 4s,自此,Siri这四个字母与苹果和iPhone牢牢绑定在了一起。

乔布斯在2010年的D8大会上接受采访时,并不觉得Siri是一个用语音助手包装起来的搜索引擎,而是一家人工智能公司,他心里非常清楚,收购Siri不是简单地为iPhone上加一个语音搜索那么简单,而是希望苹果不再局限于单一硬件,提前布局AI时代。

说苹果不重视人工智能更是扯淡,因为苹果是最早把AI硬件塞进手机里的厂商之一。

按照苹果的说法,神经引擎是专门用于处理“特定机器学习算法”的处理核心,它为iPhone上的Face ID、Animoji和AR应用等提供支持,可以做到“每秒执行高达6000亿次操作”,从而加快部分任务的处理速度。

苹果没有使用人工智能的字眼,但神经引擎处处透露出人工智能的意味,《连线》杂志与苹果副总裁Tim Millet关于 A 系列芯片的访谈中提到,在iPhone X发布的数年前,苹果的一些工程师就提出了利用机器学习算法让iPhone的摄像头变得更智能的想法。

此后每年苹果推出的A系列芯片,不只有CPU和GPU的提升,A12、A13、A14、A15、A16……神经引擎从最初每秒6000亿次进化到了每秒17万亿计算,性能已经超越了2000年的每秒计算12.3万亿次的美国超算ASCI White,曾经106吨的庞然大物,浓缩在手机芯片的一角上,让人感慨于摩尔定律之强大。

而神经引擎也让隔壁换用苹果自研M系列芯片的Mac产品沾上了光,M1就有了媲美A14的神经核心,而最新的M2 Ultra的神经引擎更是拥有每秒31.6万亿次的巅峰算力。

可能有人会好奇,如此强大的AI性能,都为苹果用户都带来了哪些革命性的改变呢?

答案藏在了iOS、iPadOS以及macOS各种不起眼但却实用的功能里。

用户在iPad上使用Apple Pencil时,笔记软件会区分笔尖按压与手掌误触;电池软件会监测日常使用习惯,优化充电功率和时间,保护电池寿命;相机应用会在按下快门后,瞬间拍摄多张照片,通过合成来得出观感更好的照片……

包括在今年6月的WWDC上,也有一堆功能实质利用上了神经引擎,例如Vision Pro上视频通线D人脸,AirPods的根据环境和个人习惯调整的个性化音量,iOS 17中更好的键盘自动更正输入单词等等。

这些功能都有一个共性,它们通常基于本地而非云端,充分调动设备本身的算力,而苹果在近几年营销演示中也特意回避所谓的人工智能(AI),而是把iPhone、Apple Watch和iPad系统的种种改进归功于机器学习(ML)。

苹果的神经引擎也如Siri一样,掀起一场新技术普及的浪潮,在2017年5月曝出苹果要内置AI计算单元后,华为在当年9月就给麒麟970加上了NPU(神经网络单元),高通则是等到了2019年的骁龙855才内置NPU,联发科则是在自己的Helio P60芯片上引入了APU的概念,谷歌在自研的Tensor上同样搭载了edge TPU。

AI概念因内置神经引擎得以普及,普通消费者或许今天都还不清楚它能干什么,但它确确实实在看不见的角落里发挥着自己的作用。

2017年之后的苹果CEO库克,明明握着和AI相关的两把大剑——Siri和神经引擎,但在2022年至2023年的这场AI浪潮里,却没能像微软纳德拉和英伟达黄仁勋那样笑出声来。

Siri作为最早面向消费者的语音助手,本应有一个翻天覆地的变化,如同iPhone 4s到iPhone 14那样的升级,但十多年过去后,大家发现它却和最初一样美国苹果id注册了,谈不上好用。

有媒体评论道,每个使用Siri的人都有自己的挫败感,他们惊讶的不是Siri的智能,而是它的愚蠢,即使是简单而明确的指令,也有可能出错,苹果前营销主管席勒口中“谦逊的个人助理”仍然保持自己谦逊的态度:移动设备上不如Google Assistant,在智能音箱上被亚马逊的Alexa完败。

事实上,苹果对Siri并没有一个完整的发展计划,最初的乔布斯野心勃勃,他的目标更接近于当初的死对头斯卡利所提出的知识导航仪,即一个能处理复杂任务的助手,但在库克继任后,Siri的目标明显更加保守了,更像是一个帮你切换各种应用的小工具,且大部分时候只能在苹果自带应用里反复横跳,一言不合就打开搜索引擎。

而神经引擎面临的情况就更复杂了,对于苹果能够内置具备AI功能的神经引擎,当时的人们都怀揣着一个未来的梦想,认为iPhone能够完成以往不能完成的任务,即使没了互联网,手机也能依靠本地计算来使用AI功能。

但事实情况并非如此,神经引擎本身不具备完全的计算能力,需要与CPU、GPU以及ISP等核心协调才能发挥作用,且算力有限,在大部分场景中,手机依旧需要连接到网络才能使用各种宣称中的功能,而Siri更是完全依托于服务器的数据。

Siri和神经引擎,一软件一硬件,本来应当是苹果应对AI时代的利器,结果在生成式AI的对比下,反倒成了短板,库克避而不谈并不是出于对AI的隐患,而是真的没啥好谈的。

当苹果昂首阔步发布Vision Pro时,先进的人机交互惊艳了任何一个视频观众,它的目的是在虚拟世界里打通生活与工作,与之相反的是,许多人渴望的不是一个华丽界面的终端产品,而是出现像钢铁侠电影中贾维斯那样的人工智能,没有太多生成式AI技术的苹果显然做不到这一点。

库克避而不谈的事实就是,大家已经对苹果小打小闹式的AI创新厌倦了,他们不关心某项新功能所带来的一点便利,而是想要通过在苹果产品里集成GPT,获得一个更加智能的Siri。

苹果当然意识到了这一点,彭博社的最新爆料里提到,苹果已经建立了自己的大型语言模型,其基于谷歌的Jax机器学习框架构建,运行在 Google Cloud 上,一部分工程师称其为“Apple GPT”,消息一发布,苹果当日的股价就上涨了2.3%,达到了历史新高,从早前的跌势中反弹。

即使到了这个时候,苹果依旧保持着相对谨慎的态度,彭博社提到,Apple GPT只是去年苹果内部一个小团队的产品,本质上是对Bard、ChatGPT 和Bing AI的简单复制,并不包含任何新颖的功能或技术,且具有不适合大众消费使用的精简设计。

不过,一旦开始决心去训练更大的模型,苹果马上就会面临比生成式AI技术更困难的问题——缺芯,准确来说,是缺GPU。

为了支撑OpenAI训练出ChatGPT,微软专门为OpenAI打造了由数万个A100 GPU组成的AI超算,60多个数据中心和几十万张GPU日夜不停歇,只为了支持ChatGPT工作。

TrendForce研究认为,以A100的算力为基础,GPT-3.5大模型需要高达2万个GPU,未来商业化后可能需要超过3万个。

以苹果产品的用户基数,一旦集成在系统中,那需要的可能是数以十万计的英伟达GPU,这么大的需求缺口,即使掏空英伟达,也很难一口气拿出这么多芯片,况且如今用于AI训练的GPU本身就极为紧俏,短时间内难以搭建媲美微软和谷歌那样的超算与数据中心。

而GPU的价格更是棘手,苹果即使再财大气粗,掏钱买几万张A100或H100的GPU还是会感到肉疼的,纵使千亿美金的家底也禁不起随便挥霍。

那么摆在苹果面前的选择似乎只剩下了一个,就是学谷歌和微软,推出类似TPU和代号雅典娜那样用于AI计算的芯片,至少能取代一部分英伟达GPU,降低训练大模型的成本。

从这个角度来看,苹果相比谷歌和微软又有了不少优势,作为硬件厂商的它,已经有A系列和M系列等自研芯片的经验,再加上代工厂台积电的鼎力支持,外界的压力依旧存在,但理论上遇到的阻力却会小上不少。

乔布斯在离任苹果CEO前,主导了对Siri的收购,这曾是苹果诸多未来美好愿景中的一个,而近两年中人工智能的异军突起,又让人想起了2011年时的种种盛况,只是这次,苹果并未站在聚光灯之下。

当各家的GPU各显神通之际,苹果会用A4和M1这样的芯片再次完成一场革命吗?